【资料简介】

Welcome to Machine Learning Algorithms From Scratch. This is your guide to learning the details of machine learning algorithms by implementing them from scratch in Python. You will discover how to load data, evaluate models and implement a suite of top machine learning algorithms using step-by-step

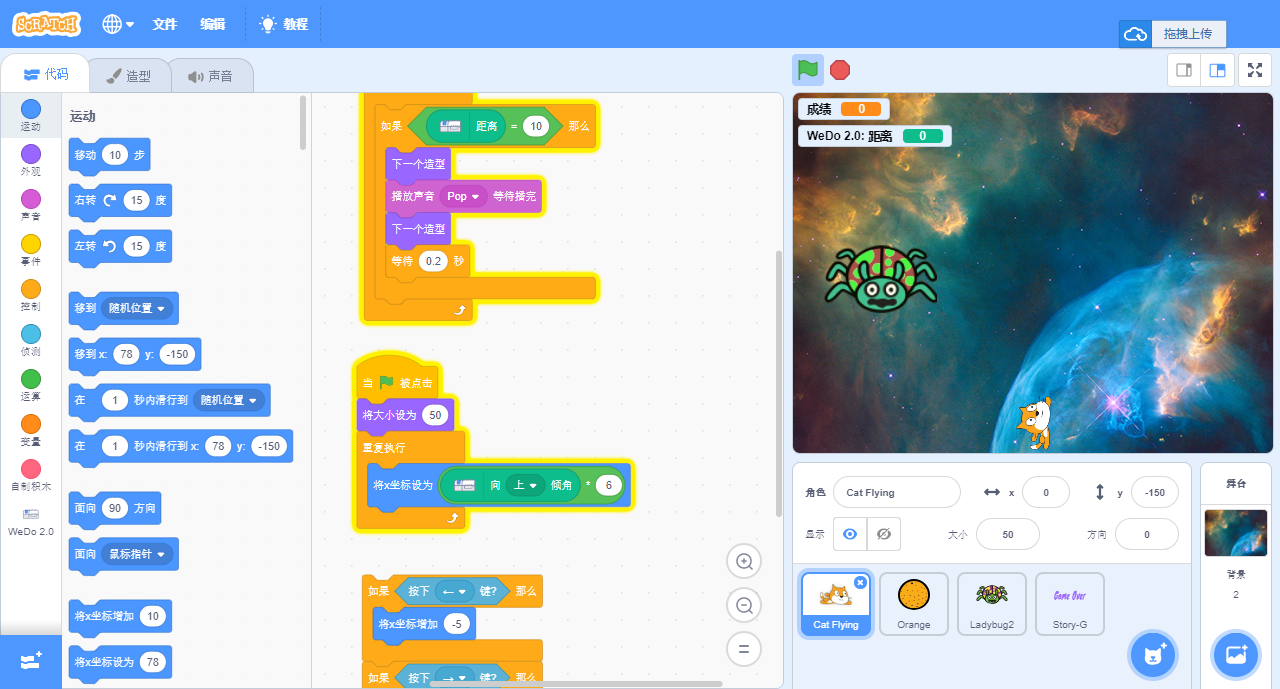

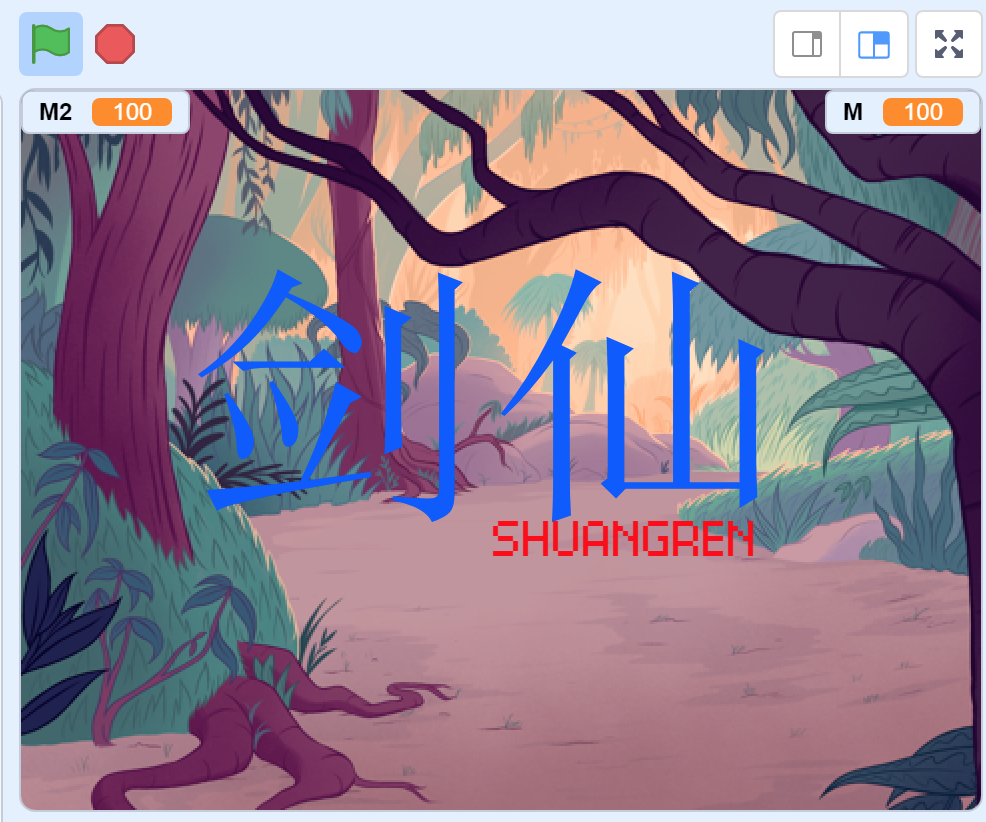

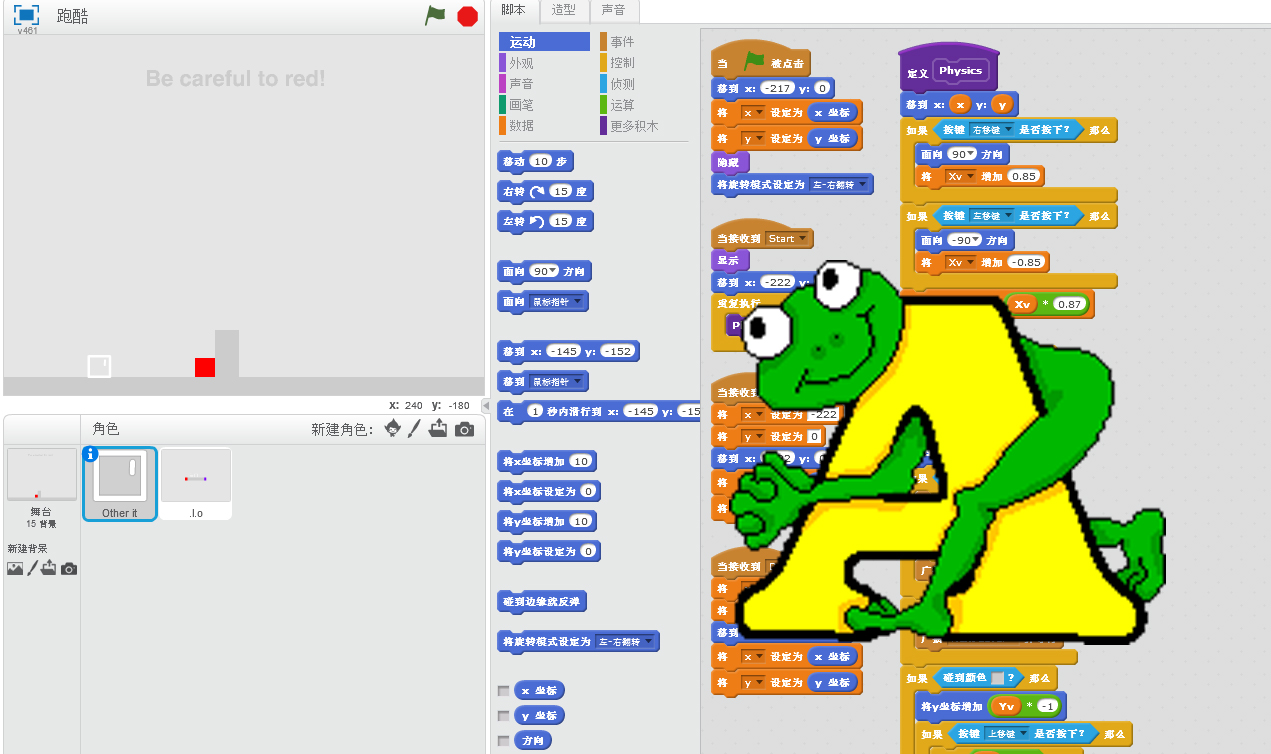

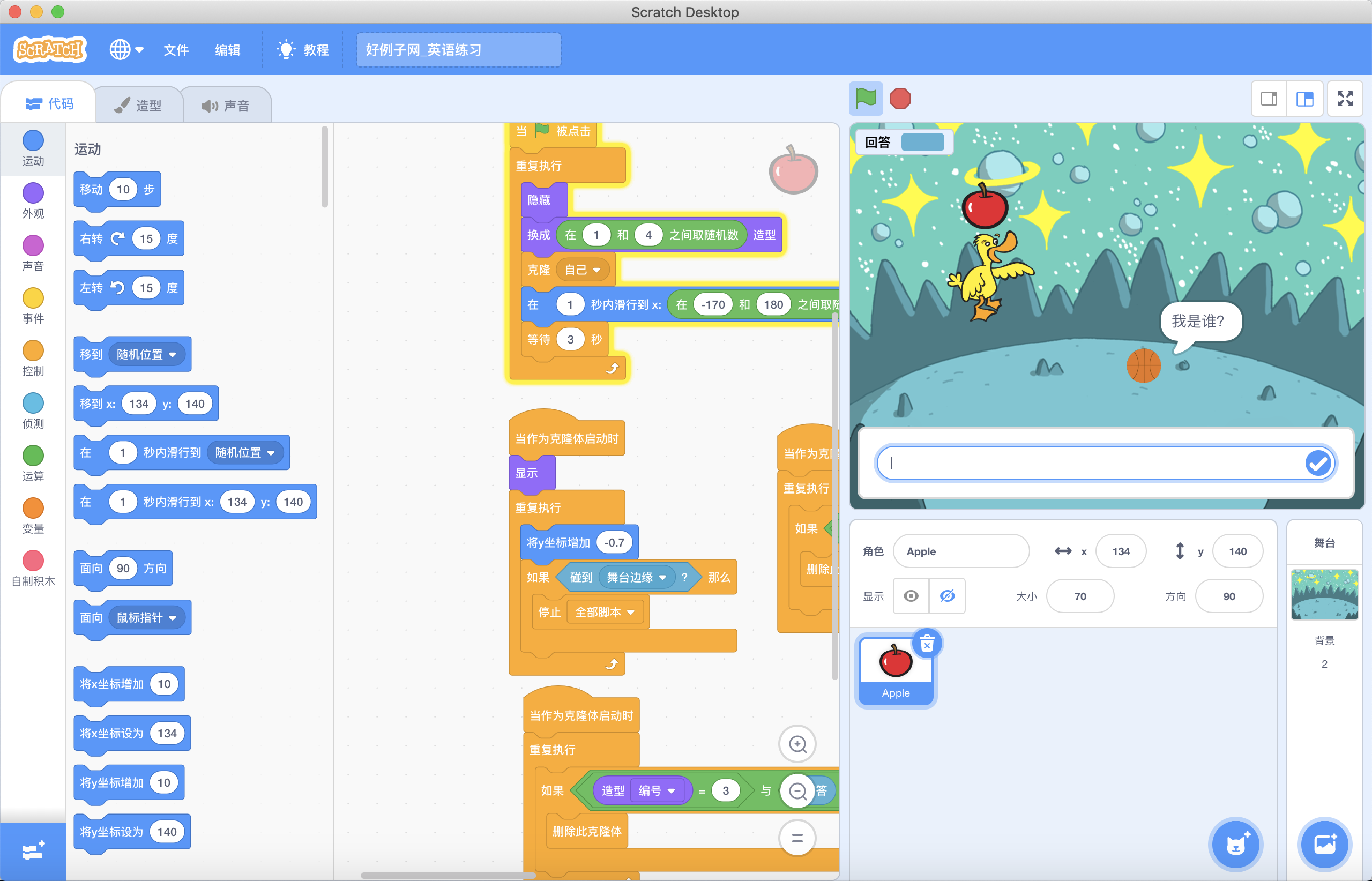

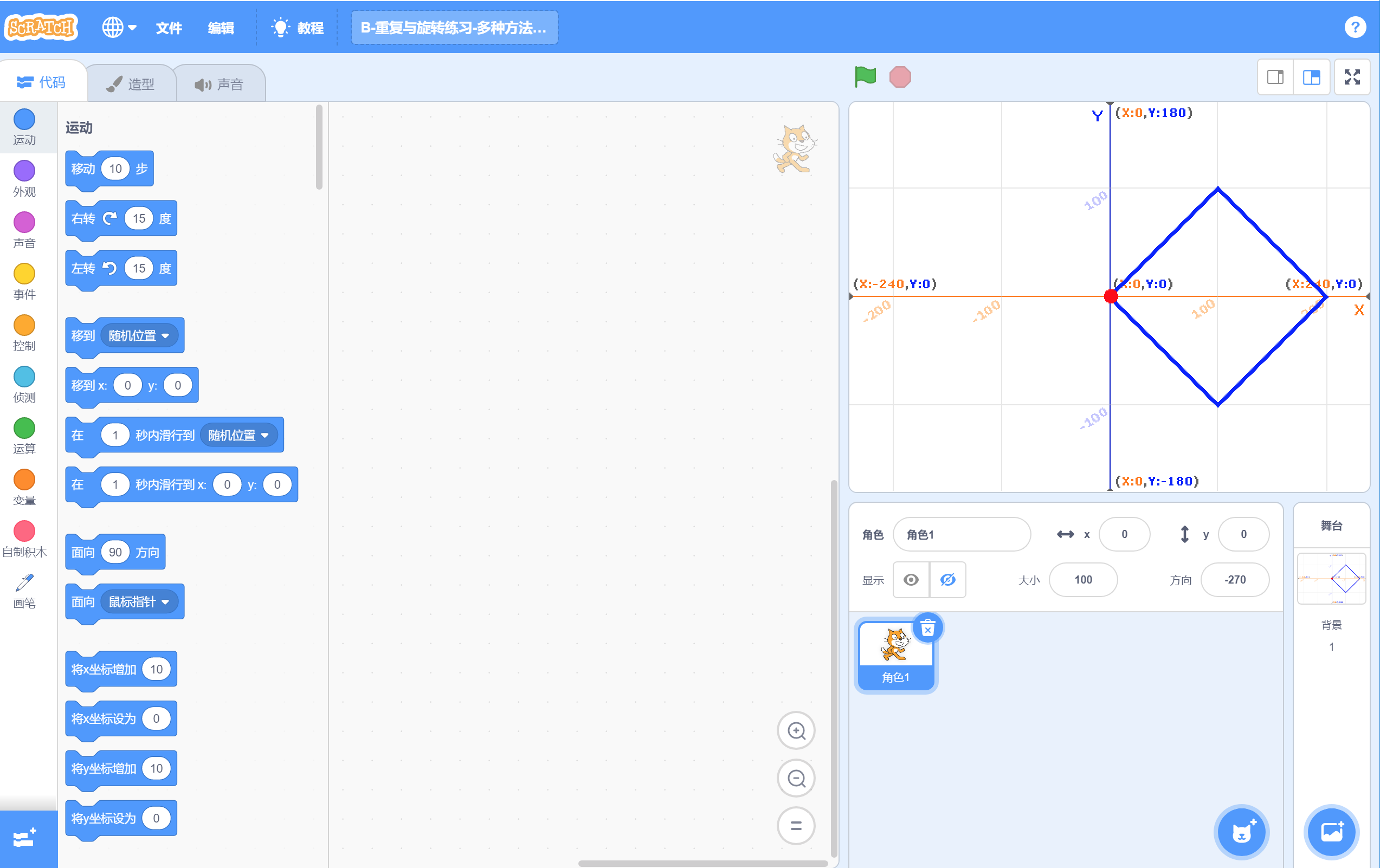

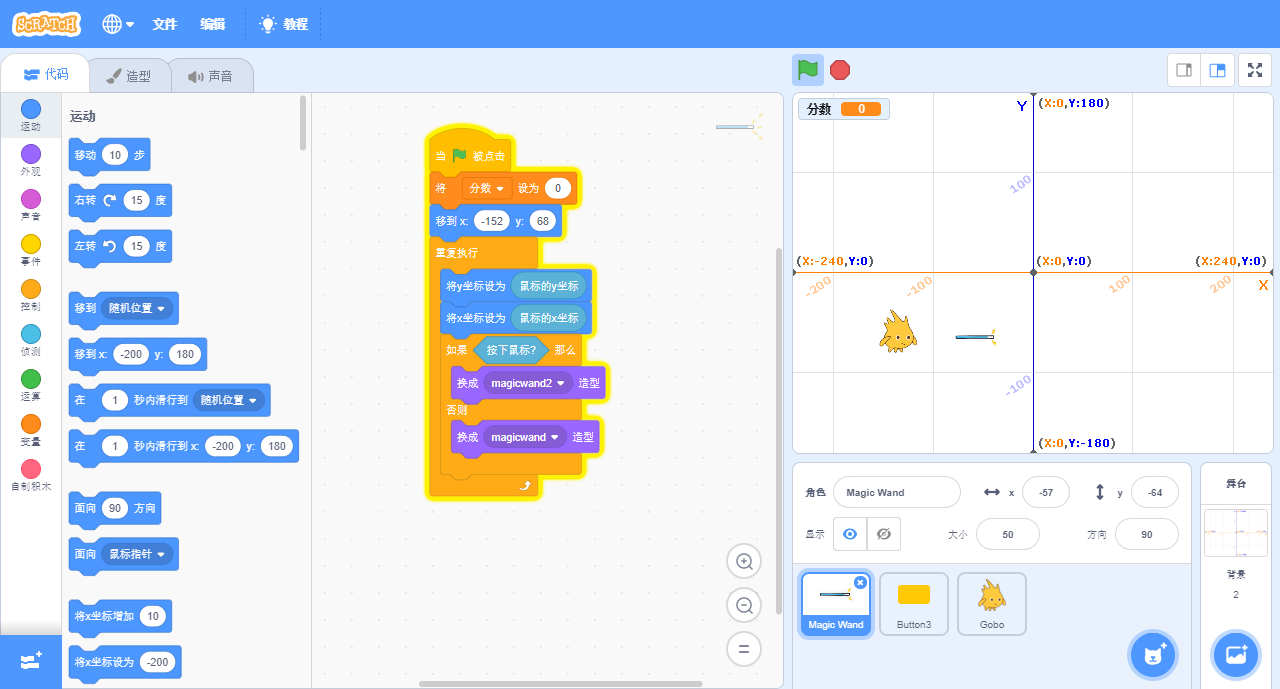

【资料截图】

【核心代码】

b47e4f22-3248-41e5-afb5-f61d6f125ff7

├── machine_learning_algorithms_from_scratch

│ ├── code

│ │ ├── chapter_01

│ │ │ ├── convert_string_to_float.py

│ │ │ ├── convert_string_to_int.py

│ │ │ ├── iris.csv

│ │ │ ├── load_csv_better.py

│ │ │ ├── load_csv.py

│ │ │ └── pima-indians-diabetes.csv

│ │ ├── chapter_02

│ │ │ ├── dataset_min_max.py

│ │ │ ├── normalize_contrived_dataset.py

│ │ │ ├── normalize_diabetes.py

│ │ │ ├── pima-indians-diabetes.csv

│ │ │ ├── standardize_contrived_dataset.py

│ │ │ ├── standardize_diabetes.py

│ │ │ └── statistics_contrived_dataset.py

│ │ ├── chapter_03

│ │ │ ├── cross_validation_split.py

│ │ │ └── split_train_test.py

│ │ ├── chapter_04

│ │ │ ├── classification_accuracy.py

│ │ │ ├── confusion_matrix_pretty.py

│ │ │ ├── confusion_matrix.py

│ │ │ ├── mean_absolute_error.py

│ │ │ └── root_mean_squared_error.py

│ │ ├── chapter_05

│ │ │ ├── random_predictions.py

│ │ │ ├── zero_rule_classification.py

│ │ │ └── zero_rule_regression.py

│ │ ├── chapter_06

│ │ │ ├── harness_cross_validation.py

│ │ │ ├── harness_train_test.py

│ │ │ └── pima-indians-diabetes.csv

│ │ ├── chapter_07

│ │ │ ├── calculate_coefficients.py

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── covariance.py

│ │ │ ├── insurance.csv

│ │ │ ├── insurance-dataset.xlsx

│ │ │ ├── mean_and_variance.py

│ │ │ ├── simple_linear_regression_contrived.py

│ │ │ └── simple_linear_regression_insurance.py

│ │ ├── chapter_08

│ │ │ ├── coefficients.py

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── linear_regression_wine_quality.py

│ │ │ ├── predict.py

│ │ │ └── winequality-white.csv

│ │ ├── chapter_09

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── estimate_coefficients.py

│ │ │ ├── logistic_regression_diabetes.py

│ │ │ ├── pima-indians-diabetes.csv

│ │ │ └── predict.py

│ │ ├── chapter_10

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── estimate_weights.py

│ │ │ ├── perceptron_predictions.py

│ │ │ ├── perceptron_sonar.py

│ │ │ └── sonar.all-data.csv

│ │ ├── chapter_11

│ │ │ ├── cart_banknote.py

│ │ │ ├── contrived_dataset.xlsx

│ │ │ ├── create_tree.py

│ │ │ ├── data_banknote_authentication.csv

│ │ │ ├── gini_split.py

│ │ │ ├── make_prediction.py

│ │ │ └── split_dataset.py

│ │ ├── chapter_12

│ │ │ ├── contrived_dataset.xlsx

│ │ │ ├── gaussian_pdf.py

│ │ │ ├── iris.csv

│ │ │ ├── naive_bayes_iris.py

│ │ │ ├── probabilities_by_class.py

│ │ │ ├── separate_by_class.py

│ │ │ ├── summarize_by_class.py

│ │ │ └── summarize_dataset.py

│ │ ├── chapter_13

│ │ │ ├── abalone.csv

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── euclidean_distance.py

│ │ │ ├── get_neighbors.py

│ │ │ ├── knn_classification_abalone.py

│ │ │ ├── knn_regression_abalone.py

│ │ │ └── make_predictions.py

│ │ ├── chapter_14

│ │ │ ├── best_matching_unit.py

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── euclidean_distance.py

│ │ │ ├── ionosphere.csv

│ │ │ ├── learning_rate.xlsx

│ │ │ ├── lvq_ionosphere.py

│ │ │ └── train_codebook_vectors.py

│ │ ├── chapter_15

│ │ │ ├── backpropagate_error.py

│ │ │ ├── backpropagation_seeds.py

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── forward_propagate.py

│ │ │ ├── initialize_network.py

│ │ │ ├── predict.py

│ │ │ ├── seeds_dataset.csv

│ │ │ └── train_network.py

│ │ ├── chapter_16

│ │ │ ├── bagging_sonar.py

│ │ │ ├── sonar.all-data.csv

│ │ │ └── subsample.py

│ │ ├── chapter_17

│ │ │ ├── random_forest_sonar.py

│ │ │ └── sonar.all-data.csv

│ │ └── chapter_18

│ │ ├── sonar.all-data.csv

│ │ └── stacking_sonar.py

│ ├── machine_learning_algorithms_from_scratch.pdf

│ └── README.txt

└── __MACOSX

└── machine_learning_algorithms_from_scratch

└── code

├── chapter_01

├── chapter_02

├── chapter_03

├── chapter_04

├── chapter_05

├── chapter_06

├── chapter_07

├── chapter_08

├── chapter_09

├── chapter_10

├── chapter_11

├── chapter_12

├── chapter_13

├── chapter_14

├── chapter_15

├── chapter_16

├── chapter_17

└── chapter_18

41 directories, 95 files

Welcome to Machine Learning Algorithms From Scratch. This is your guide to learning the details of machine learning algorithms by implementing them from scratch in Python. You will discover how to load data, evaluate models and implement a suite of top machine learning algorithms using step-by-step

【资料截图】

【核心代码】

b47e4f22-3248-41e5-afb5-f61d6f125ff7

├── machine_learning_algorithms_from_scratch

│ ├── code

│ │ ├── chapter_01

│ │ │ ├── convert_string_to_float.py

│ │ │ ├── convert_string_to_int.py

│ │ │ ├── iris.csv

│ │ │ ├── load_csv_better.py

│ │ │ ├── load_csv.py

│ │ │ └── pima-indians-diabetes.csv

│ │ ├── chapter_02

│ │ │ ├── dataset_min_max.py

│ │ │ ├── normalize_contrived_dataset.py

│ │ │ ├── normalize_diabetes.py

│ │ │ ├── pima-indians-diabetes.csv

│ │ │ ├── standardize_contrived_dataset.py

│ │ │ ├── standardize_diabetes.py

│ │ │ └── statistics_contrived_dataset.py

│ │ ├── chapter_03

│ │ │ ├── cross_validation_split.py

│ │ │ └── split_train_test.py

│ │ ├── chapter_04

│ │ │ ├── classification_accuracy.py

│ │ │ ├── confusion_matrix_pretty.py

│ │ │ ├── confusion_matrix.py

│ │ │ ├── mean_absolute_error.py

│ │ │ └── root_mean_squared_error.py

│ │ ├── chapter_05

│ │ │ ├── random_predictions.py

│ │ │ ├── zero_rule_classification.py

│ │ │ └── zero_rule_regression.py

│ │ ├── chapter_06

│ │ │ ├── harness_cross_validation.py

│ │ │ ├── harness_train_test.py

│ │ │ └── pima-indians-diabetes.csv

│ │ ├── chapter_07

│ │ │ ├── calculate_coefficients.py

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── covariance.py

│ │ │ ├── insurance.csv

│ │ │ ├── insurance-dataset.xlsx

│ │ │ ├── mean_and_variance.py

│ │ │ ├── simple_linear_regression_contrived.py

│ │ │ └── simple_linear_regression_insurance.py

│ │ ├── chapter_08

│ │ │ ├── coefficients.py

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── linear_regression_wine_quality.py

│ │ │ ├── predict.py

│ │ │ └── winequality-white.csv

│ │ ├── chapter_09

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── estimate_coefficients.py

│ │ │ ├── logistic_regression_diabetes.py

│ │ │ ├── pima-indians-diabetes.csv

│ │ │ └── predict.py

│ │ ├── chapter_10

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── estimate_weights.py

│ │ │ ├── perceptron_predictions.py

│ │ │ ├── perceptron_sonar.py

│ │ │ └── sonar.all-data.csv

│ │ ├── chapter_11

│ │ │ ├── cart_banknote.py

│ │ │ ├── contrived_dataset.xlsx

│ │ │ ├── create_tree.py

│ │ │ ├── data_banknote_authentication.csv

│ │ │ ├── gini_split.py

│ │ │ ├── make_prediction.py

│ │ │ └── split_dataset.py

│ │ ├── chapter_12

│ │ │ ├── contrived_dataset.xlsx

│ │ │ ├── gaussian_pdf.py

│ │ │ ├── iris.csv

│ │ │ ├── naive_bayes_iris.py

│ │ │ ├── probabilities_by_class.py

│ │ │ ├── separate_by_class.py

│ │ │ ├── summarize_by_class.py

│ │ │ └── summarize_dataset.py

│ │ ├── chapter_13

│ │ │ ├── abalone.csv

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── euclidean_distance.py

│ │ │ ├── get_neighbors.py

│ │ │ ├── knn_classification_abalone.py

│ │ │ ├── knn_regression_abalone.py

│ │ │ └── make_predictions.py

│ │ ├── chapter_14

│ │ │ ├── best_matching_unit.py

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── euclidean_distance.py

│ │ │ ├── ionosphere.csv

│ │ │ ├── learning_rate.xlsx

│ │ │ ├── lvq_ionosphere.py

│ │ │ └── train_codebook_vectors.py

│ │ ├── chapter_15

│ │ │ ├── backpropagate_error.py

│ │ │ ├── backpropagation_seeds.py

│ │ │ ├── contrived-dataset.xlsx

│ │ │ ├── forward_propagate.py

│ │ │ ├── initialize_network.py

│ │ │ ├── predict.py

│ │ │ ├── seeds_dataset.csv

│ │ │ └── train_network.py

│ │ ├── chapter_16

│ │ │ ├── bagging_sonar.py

│ │ │ ├── sonar.all-data.csv

│ │ │ └── subsample.py

│ │ ├── chapter_17

│ │ │ ├── random_forest_sonar.py

│ │ │ └── sonar.all-data.csv

│ │ └── chapter_18

│ │ ├── sonar.all-data.csv

│ │ └── stacking_sonar.py

│ ├── machine_learning_algorithms_from_scratch.pdf

│ └── README.txt

└── __MACOSX

└── machine_learning_algorithms_from_scratch

└── code

├── chapter_01

├── chapter_02

├── chapter_03

├── chapter_04

├── chapter_05

├── chapter_06

├── chapter_07

├── chapter_08

├── chapter_09

├── chapter_10

├── chapter_11

├── chapter_12

├── chapter_13

├── chapter_14

├── chapter_15

├── chapter_16

├── chapter_17

└── chapter_18

41 directories, 95 files